Digitalisasi Dunia

AI Mini Tapi Pintar, Kok Bisa?

6 Mei 2025

Kecerdasan buatan (AI) sering dikaitkan dengan infrastruktur besar seperti superkomputer mahal dan pusat data berpendingin khusus. Namun, dengan kemajuan dalam optimalisasi model dan pengembangan arsitektur efisien, AI kini dapat diakses tanpa infrastruktur besar. Model-model kecil yang cepat dan hemat sumber daya dapat dijalankan pada perangkat sehari-hari seperti laptop, smartphone, dan perangkat IoT. Model-model ini, yang dikenal sebagai Small Language Models (SLM), mengubah cara kita memandang AI.

Membongkar Mitos Besar, Apakah AI Itu Harus Berat dan Mahal?

Selama bertahun-tahun, kecerdasan buatan (AI) dianggap hanya bisa berfungsi dengan dukungan infrastruktur besar, seperti server besar, jaringan internet cepat, dan konsumsi energi yang tinggi. Pandangan ini muncul di masa awal AI generatif, ketika model-model seperti GPT-3 dan DALL·E memerlukan biaya jutaan dolar hanya untuk pelatihan.

Namun, seiring kemajuan teknologi dan munculnya berbagai inovasi, biaya untuk melatih model AI mulai menurun secara signifikan. Contohnya, teknologi seperti DeepSeek yang tiba-tiba muncul dengan biaya pelatihan jauh lebih rendah menunjukkan bahwa tren ini mulai berubah.

Berkat inovasi dalam desain model dan algoritma yang lebih efisien, AI kini juga hadir dalam bentuk yang lebih ringan yang dioptimalkan untuk tugas-tugas spesifik, yang dikenal dengan nama Small Language Models (SLM).

Mengenal SLM (Small Language Model): AI Kecil, Performa Besar

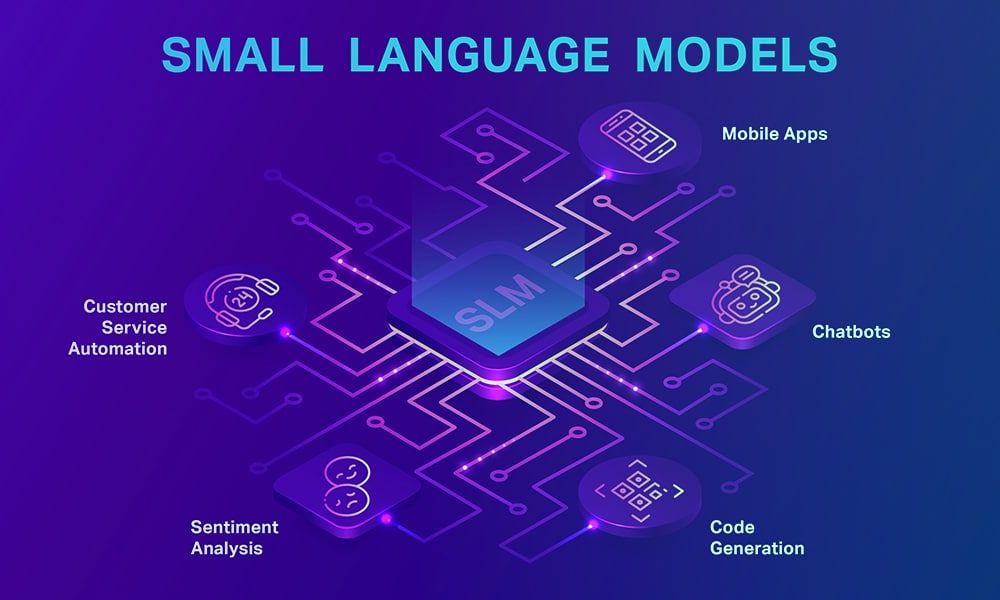

SLM adalah model bahasa yang berukuran lebih kecil dibandingkan model besar seperti GPT-3 atau GPT-4. SLM menggunakan sumber daya komputasi yang jauh lebih rendah, tapi tetap mampu memberikan manfaat yang signifikan.

Dalam SLM, arsitektur dirancang agar lebih sederhana dan efisien dengan memilih elemen-elemen yang paling penting untuk tugas tertentu. Daripada mengandalkan data dan sumber daya yang besar untuk menghasilkan hasil yang kompleks, SLM lebih fokus pada penyederhanaan proses, mengutamakan tugas-tugas spesifik, dan menyaring informasi yang kurang relevan. Hal ini membuka jalan bagi ekosistem AI yang lebih terjangkau, mudah diakses, dan bisa dimanfaatkan oleh berbagai sektor industri tanpa perlu anggaran besar.

https://www.shaip.com/blog/small-language-models-real-word-example-and-training-data/

Small Language Models (SLM) merupakan inovasi dalam dunia kecerdasan buatan yang menawarkan kecanggihan AI, namun dengan ukuran dan kebutuhan komputasi yang jauh lebih kecil.

SLM memiliki jumlah parameter yang bervariasi, mulai dari beberapa juta hingga miliaran, sementara LLM memiliki ratusan miliar bahkan triliunan parameter. Sebagai contoh, Phi-4, SLM terbaru milik Microsoft, memiliki 14 miliar parameter sedangkan GPT-4.5, LLM terbaru milik OpenAI, diperkirakan memiliki 4 hingga 5 triliun parameter.

SLM menunjukkan bahwa AI tidak harus besar atau mahal untuk memberikan manfaat. SLM dapat dijalankan langsung di perangkat lokal, dengan penggunaan daya dan sumber daya komputasi yang lebih rendah.

Beberapa contoh SLM yang telah dirilis:

1. Phi-4 Mini

Salah satu contoh SLM yang menarik adalah Phi-4 Mini dari Microsoft. Model ini merupakan versi kecil dari Phi-4 yang lebih besar, namun tetap menghadirkan kemampuan yang mengesankan dalam pemrosesan bahasa alami dan berbagai aplikasi AI. Phi-4 Mini adalah model bahasa dengan 3,8 miliar parameter yang dilatih menggunakan data sintetis berkualitas tinggi dan data web terkurasi. Menurut laporan dari Microsoft Research pada 2024, Phi-4 Mini dapat melakukan tugas-tugas seperti pengenalan bahasa, pemrosesan teks, dan respons cerdas, hanya dengan memanfaatkan sebagian kecil dari daya komputasi yang dibutuhkan oleh model besar seperti GPT-4.

2. Gemma 7B

Google DeepMind juga tidak ketinggalan dengan model kecil mereka, Gemma 7B. Dengan pendekatan yang sama, Gemma 7B dengan 7 miliar parameter tetap mampu menangani berbagai tugas kompleks dalam skala kecil, seperti analisis teks dan pemrosesan bahasa alami, dengan biaya komputasi yang lebih rendah. Dengan sistem yang dioptimalkan untuk berjalan langsung di perangkat, Gemma 7B juga menjamin penghematan daya, yang menjadikannya ideal untuk penggunaan perangkat mobile dan IoT.

3. Mistral-NeMo-Minitron 8B

Mistral-NeMo-Minitron 8B adalah versi lebih kecil dari model Mistral NeMo 12B yang dirilis oleh Mistral AI dan NVIDIA. Minitron 8B dibuat menggunakan teknik machine learning seperti pemangkasan (pruning) dan distilasi, yang mengurangi kebutuhan hardware sambil menjaga kualitas hasil. Pruning bertujuan untuk menghilangkan komponen/parameter yang kurang relevan untuk meningkatkan efisiensi model, sementara distilasi memindahkan pengetahuan dari model AI besar ke model yang lebih kecil dan efisien, dalam hal ini mengurangi parameter model dari 12 miliar menjadi 8 miliar. Pendekatan ini memungkinkan Minitron 8B berjalan di workstation bertenaga Nvidia RTX dan unggul dalam uji coba untuk chatbot, asisten virtual, dan pembuatan konten.

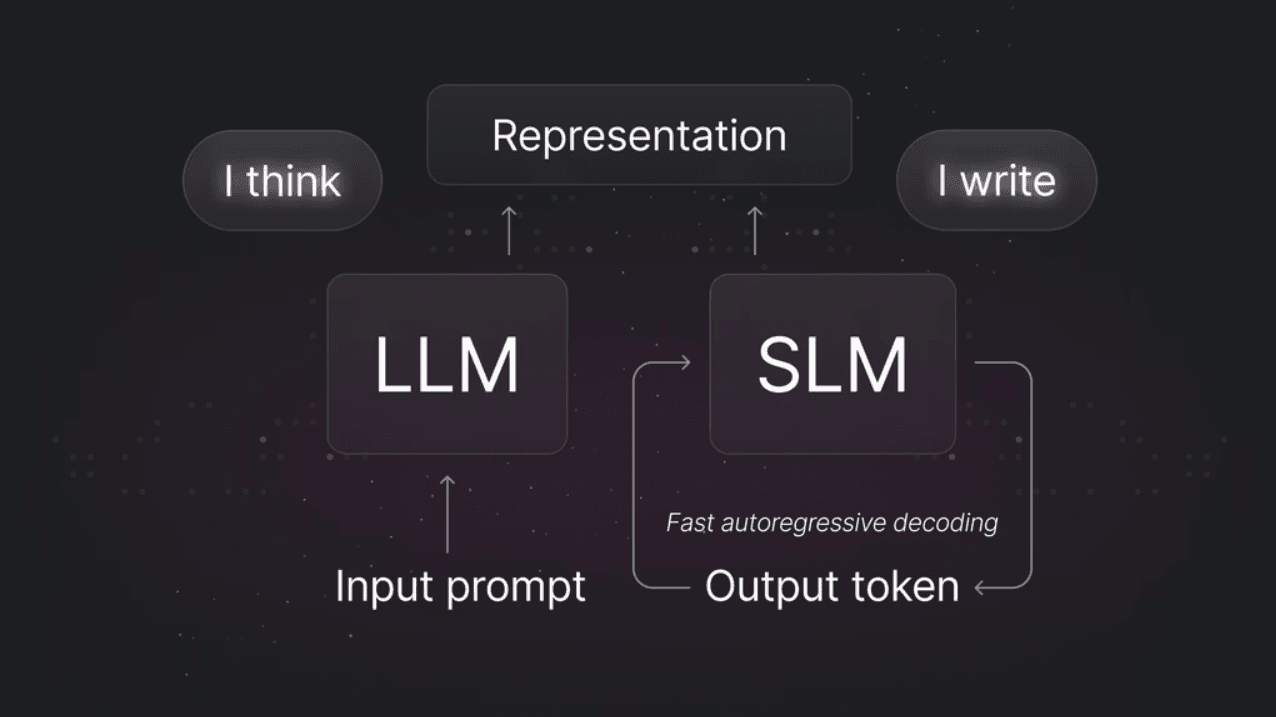

SLM vs LLM (Large Language Model): Apa Perbedaan di antara Mereka?

SLM (Small Language Models) dan LLM (Large Language Models) memiliki perbedaan mendasar yang bergantung pada kebutuhan penggunaannya:

1. LLM dan SLM biasanya dilatih dengan set data yang berbeda

Perbedaan utama antara LLM dan SLM dapat terlihat pada jenis data yang digunakan untuk pelatihan mereka. LLM, seperti GPT-4/ChatGPT, biasanya dilatih dengan data dalam jumlah besar dari berbagai sumber, termasuk seluruh internet hingga batas waktu tertentu. Hal ini memungkinkan GPT-4/ChatGPT untuk menjawab berbagai jenis pertanyaan dari pengguna umum, namun juga membuatnya rentan terhadap kesalahan atau jawaban yang tidak akurat, yang sering disebut "halusinasi," karena kurangnya pelatihan khusus di bidang tertentu.

Sementara itu, SLM dilatih dengan data yang lebih kecil dan spesifik, disesuaikan dengan kebutuhan industri tertentu. Misalnya, sebuah chatbot di bidang kesehatan bisa dilatih menggunakan data medis untuk memberikan jawaban yang lebih tepat pada pertanyaan kesehatan dari pengguna awam, tanpa perlu dilatih dengan data yang tidak relevan seperti blog atau novel.

Singkatnya, SLM biasanya unggul dalam bidang tertentu, tetapi kurang mampu dibandingkan LLM dalam hal pengetahuan umum dan pemahaman konteks secara keseluruhan.

2. LLM dan SLM memerlukan sumber daya yang berbeda

Melatih model AI, baik LLM maupun SLM, adalah proses yang memerlukan banyak sumber daya. Namun, pelatihan LLM jauh lebih intensif. Sebagai contoh, GPT-4 memerlukan 25,000 GPU NVIDIA A100 yang berjalan simultan selama 90-100 hari. Pelatihan SLM tetap membutuhkan sumber daya komputasi yang signifikan, tetapi jauh lebih sedikit dibandingkan LLM.

3. LLM dan SLM memiliki trade-off masing-masing antara kecepatan, keamanan, akurasi, dan fleksibilitas

Setiap model datang dengan serangkaian kelebihan dan kekurangan, yang berkaitan dengan berbagai faktor, seperti kecepatan, keamanan, akurasi, dan fleksibilitas.

Kecepatan: SLM lebih cepat dalam menjalankan tugas spesifik, terutama saat dijalankan langsung di perangkat pengguna, seperti Phi-4 Mini yang tidak perlu mengirim data ke server. Sementara itu, LLM cenderung lebih lambat karena bergantung pada server jarak jauh untuk pemrosesan.

Keamanan: SLM unggul dalam keamanan karena memproses data langsung di perangkat, mengurangi risiko kebocoran data. Sebaliknya, LLM lebih rentan terhadap masalah privasi karena memerlukan koneksi ke cloud untuk pemrosesan data.

Akurasi dan Fleksibilitas: LLM lebih akurat dan fleksibel dalam menangani berbagai tugas kompleks. LLM dapat memahami konteks dalam percakapan rumit. Sementara SLM lebih efisien dan cepat, tetapi mungkin kurang akurat untuk tugas kompleks.

Kapan Sebaiknya Memilih SLM atau LLM?

Membuat keputusan antara memilih Small Language Models (SLM) atau Large Language Models (LLM) sangat bergantung pada objective dan seberapa banyak sumber daya yang tersedia.

SLM Cocok Untuk:

Tugas spesifik: SLM ideal untuk tugas spesifik seperti analisis teks atau identifikasi pola, yang tidak memerlukan fleksibilitas tinggi. Dengan efisiensi sumber daya, SLM dapat menyelesaikan tugas-tugas ini dengan cepat tanpa membebani perangkat atau server.

Device berbasis AI: SLM cocok untuk perangkat lokal seperti smartphone atau IoT, memproses data langsung di perangkat tanpa mengirim ke cloud, sehingga lebih cepat, hemat biaya, dan menjaga privasi. Model seperti Phi-4 Mini atau Mistral 7B ideal untuk aplikasi ini.

Penerapan yang sensitif terhadap biaya: Jika anggaran terbatas, SLM adalah pilihan yang tepat. SLM menawarkan solusi AI yang efisien dan terjangkau tanpa memerlukan investasi besar dalam infrastruktur cloud atau server.

LLM Cocok Untuk:

Tugas kompleks: Untuk melakukan tugas yang kompleks, seperti analisis dokumen yang panjang dan rumit, LLM lebih cocok. Sebagai contoh, dalam menganalisa dokumen hukum, model besar ini mampu memahami nuansa hukum yang kompleks, mencari pasal relevan, dan memberikan analisis mendalam. Keakuratan dan fleksibilitas yang tinggi sangat dibutuhkan meskipun dengan biaya dan kebutuhan komputasi yang lebih besar.

Konten Kreatif: Untuk tugas yang membutuhkan kreativitas tinggi, seperti penulisan artikel atau pembuatan konten marketing, LLM unggul dalam menghasilkan teks yang variatif, kreatif, dan terperinci, cocok untuk narasi kreatif atau percakapan alami.

Percakapan kompleks dan mendalam: LLM unggul dalam hal percakapan yang bersifat mendalam dan berkelanjutan. Misalnya, LLM dapat digunakan untuk membangun chatbot yang tidak hanya dapat menjawab pertanyaan basic/sederhana tetapi juga mengikuti percakapan yang lebih kompleks dan lebih natural.

Kesimpulan: Apa yang Harus Dipertimbangkan Dalam Memilih Model yang Akan Kita Gunakan?

Selain biaya dan kompleksitas tugas, isu keamanan data juga penting diperhatikan saat memilih model AI.

Small Language Models (SLM) mengolah data secara lokal sehingga mengurangi risiko kebocoran, sangat ideal untuk data sensitif, sedangkan Large Language Models (LLM) bergantung pada cloud dan memproses data di server jarak jauh yang berpotensi menambah risiko privasi. Kedua model tersebut memiliki keunggulan masing-masing; SLM menawarkan efisiensi, keamanan, dan biaya rendah untuk tugas sederhana, sementara LLM unggul dalam menangani tugas kompleks dengan analisis yang lebih mendalam.

Oleh karena itu, pemilihan model yang tepat sesuai kebutuhan menjadi kunci untuk meraih keunggulan kompetitif di era AI yang terus berkembang.